Компания NVIDIA давно зарекомендовала себя не только как производитель графических ускорителей, но и как разработчик любопытных программных инструментов. В 2020 году в открытую бету вышла облачная платформа Omniverse, предназначенная для физически корректного моделирования в виртуальной среде в режиме реального времени. Теперь NVIDIA готова представить миру новый инструмент Audio2Face, который позволяет создавать трёхмерные лицевые анимации, способные синхронизировать свои движения с заданными аудиодорожками.

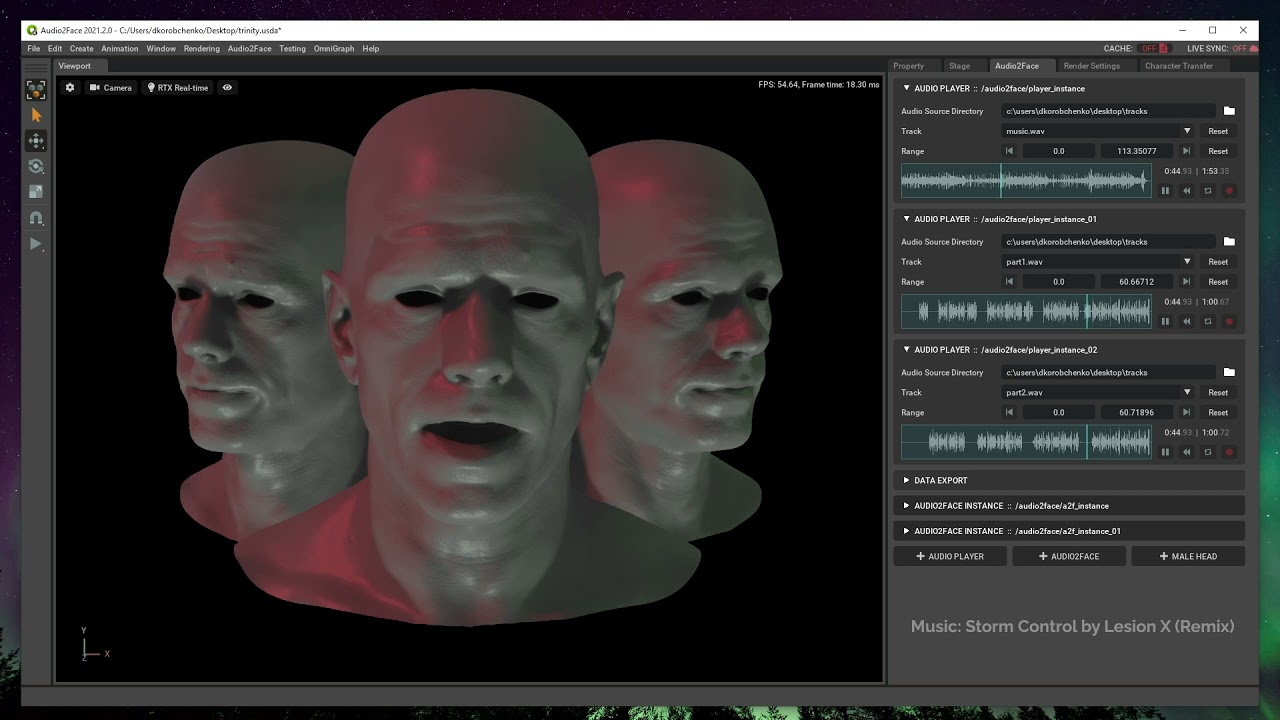

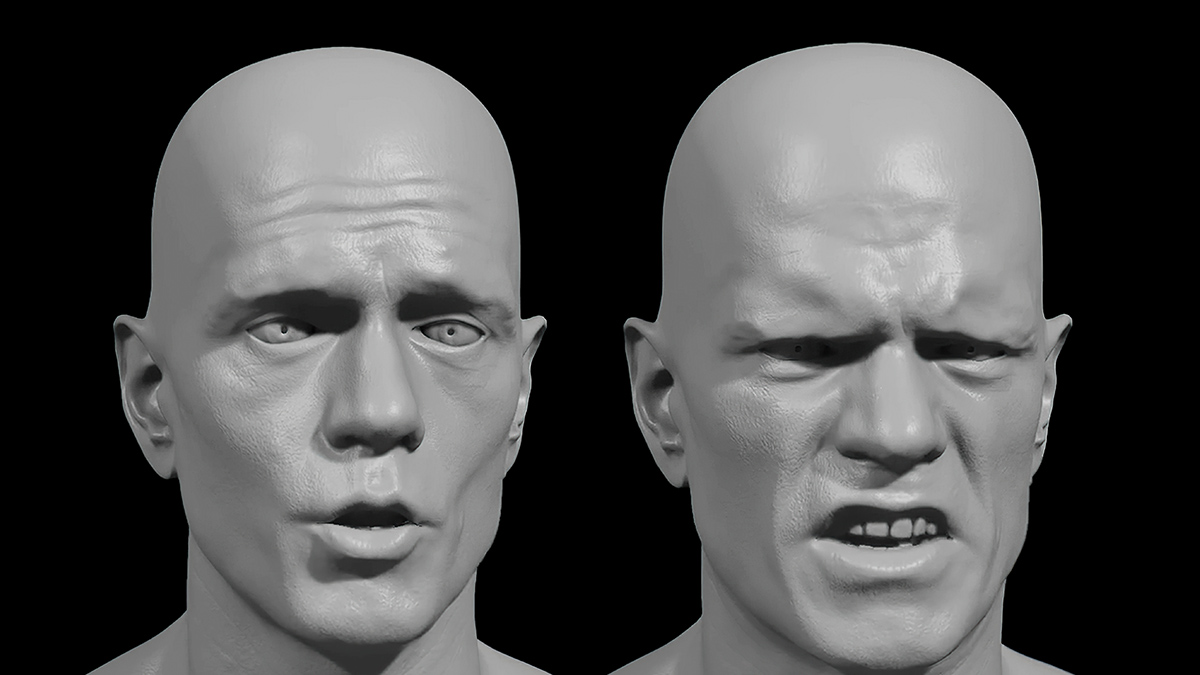

По словам представителей компании, сгенерированные лицевые анимации можно применять на любых реалистичных или стилизованных персонажах. В качестве примера на сайте Audio2Face представлена одна и та же анимация, наложенная на персонажа Digital Mark и на мультяшного носорога. Более того, платформа может поддерживать работу с неограниченным количеством героев, анимированных с применением одного или разных аудио. В обозримом будущем функционал технологии Audio2Face дополнит возможность управления эмоциями персонажей для калибровки выразительности анимаций.

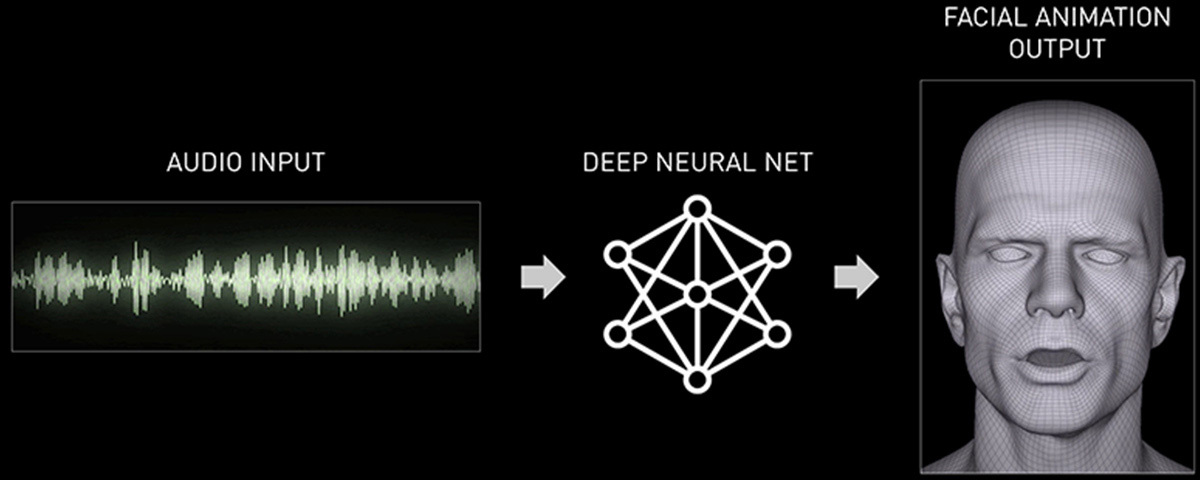

В основе инструмента Audio2Face лежит система глубокого обучения, которая подстраивает мимику и движения речевого аппарата выбранного персонажа к заданной звуковой дорожке в режиме реального времени. При первом открытии программы системе может потребоваться какое-то время для оптимизации нейросети под конкретное аппаратное обеспечение при помощи движка TensorRT. К слову, на официальном сайте Nvidia on Demand и на YouTube-канале компании имеется немало видеоуроков для ознакомления с особенностями работы платформы Omniverse и технологии Audio2Face. С их помощью пользователи могут научиться создавать собственные анимированные модели, переносить готовые анимации на различных персонажей, экспортировать результат на другие платформы вроде Epic Games Unreal Engine 4, а также импортировать персонажей, созданных при помощи других инструментов (MetaHuman, Epic Games Unreal Engine 4 и др.).

Стоит отметить, что на этапе бета-тестирования Audio2Face технология всё ещё не совершенна. В частности, правдоподобность синхронизации анимации с речью сильно зависит от качества оригинальной аудиодорожки. К примеру, в одном из роликов на YouTube-канале On Set Facilities представлен отрезок речи Чарли Чаплина из «Великого диктатора» (первого полностью звукового фильма в его карьере), перенесённый на базового персонажа Digital Mark. Из-за низкого качества аудиозаписи анимированная модель не может в полной мере повторить мимику и движения речевого аппарата цирюльника-лжедиктатора. Впрочем, в NVIDIA уверены, что в будущем качество звука перестанет быть препятствием для полноценной реализации технологии Audio2Face.