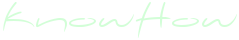

Одной из самых зловещих функций современных генеративно-состязательных ИИ является возможность воспроизведения голосов реальных людей по секундным записям их речи. Новый программный инструмент AntiFake, разработанный учёными из Университета Вашингтона в Сент-Луисе, позволит пресечь попытки злоумышленников украсть чужой голос.

Голосовые дипфейки – многогранный инструмент осуществления разнообразных преступных замыслов. Множество публичных личностей и политиков уже пострадали из-за того, что кто-то «вложил в их уста» провокационные слова, которых они никогда не говорили, для их дискредитации или дезинформации публики. Кроме того, всё больше людей получают звонки и слышат голоса знакомых, друзей или родственников, которые сообщают о каких-то срочных проблемах и просят поскорее отправить им деньги. И наконец, подобные технологии возможно использовать для обхода систем безопасности, полагающихся на технологии распознавания голоса. В связи с подобными угрозами эксперты уже активно развивают технологии, позволяющие идентифицировать голосовые дипфейки и подтвердить принадлежность голоса. Однако AntiFake – это первое программное решение, которое поможет предупредить случаи неправомерной эксплуатации чужих голосов.

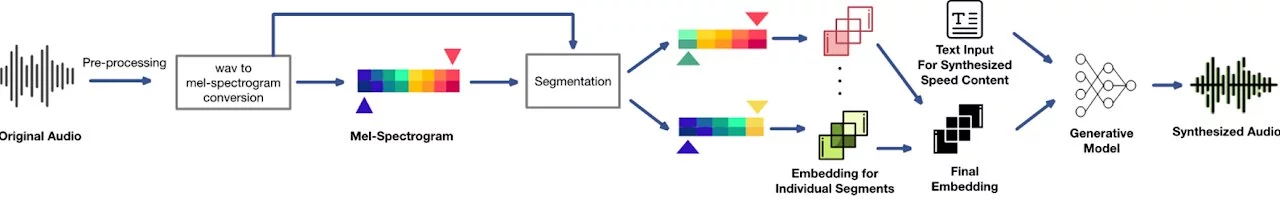

По словам разработчиков из Университета Вашингтона в Сент-Луисе, AntiFake действует за счёт «обмана» генеративно-состязательных ИИ. Подобные алгоритмы подделывают голоса людей путём имитации ключевых вокальных характеристик и особенностей речи. Разработанная учёными система усложняет для ИИ идентификацию этих параметров. Инструмент использует технику состязательного машинного обучения, которая, к слову, изначально входила в набор инструментов киберпреступников, а теперь стала всё чаще использоваться против них. Создатель системы профессор компьютерных наук и инженерии Нин Чжан пояснил, что AntiFake искажает аудиосигналы таким образом, что речь звучит совершенно неотличимой для человеческого уха, но становится недоступным для восприятия ИИ.

По словам разработчиков из Университета Вашингтона в Сент-Луисе, AntiFake действует за счёт «обмана» генеративно-состязательных ИИ. Подобные алгоритмы подделывают голоса людей путём имитации ключевых вокальных характеристик и особенностей речи. Разработанная учёными система усложняет для ИИ идентификацию этих параметров. Инструмент использует технику состязательного машинного обучения, которая, к слову, изначально входила в набор инструментов киберпреступников, а теперь стала всё чаще использоваться против них. Создатель системы профессор компьютерных наук и инженерии Нин Чжан пояснил, что AntiFake искажает аудиосигналы таким образом, что речь звучит совершенно неотличимой для человеческого уха, но становится недоступным для восприятия ИИ.

Таким образом, если кто-то попытается использовать ИИ для создания голосового дипфейка по аудио, обработанному при помощи данной системы, то алгоритм не сможет воспроизвести звучание реального голоса человека. Учёные протестировали AntiFake и обнаружили, что данная технология оказалось эффективной в 95% случаев попыток предотвратить синтез голосовых дипфейков. Чжан не исключает, что в развитие технологий машинного обучения в будущем позволит обойти и его изобретение, однако он считает, что стратегия использования техник состязательного ИИ продолжит оставаться актуальной. Чтобы привлечь больше людей к совершенствованию своего инструмента, Нин сделал его код открытым для всех желающих.

Таким образом, если кто-то попытается использовать ИИ для создания голосового дипфейка по аудио, обработанному при помощи данной системы, то алгоритм не сможет воспроизвести звучание реального голоса человека. Учёные протестировали AntiFake и обнаружили, что данная технология оказалось эффективной в 95% случаев попыток предотвратить синтез голосовых дипфейков. Чжан не исключает, что в развитие технологий машинного обучения в будущем позволит обойти и его изобретение, однако он считает, что стратегия использования техник состязательного ИИ продолжит оставаться актуальной. Чтобы привлечь больше людей к совершенствованию своего инструмента, Нин сделал его код открытым для всех желающих.

Источник: AntiFake: Using Adversarial Audio to Prevent Unauthorized Speech Synthesis / Yu, Zhiyuan and Zhai, Shixuan and Zhang, Ning

Источник: AntiFake: Using Adversarial Audio to Prevent Unauthorized Speech Synthesis / Yu, Zhiyuan and Zhai, Shixuan and Zhang, Ning