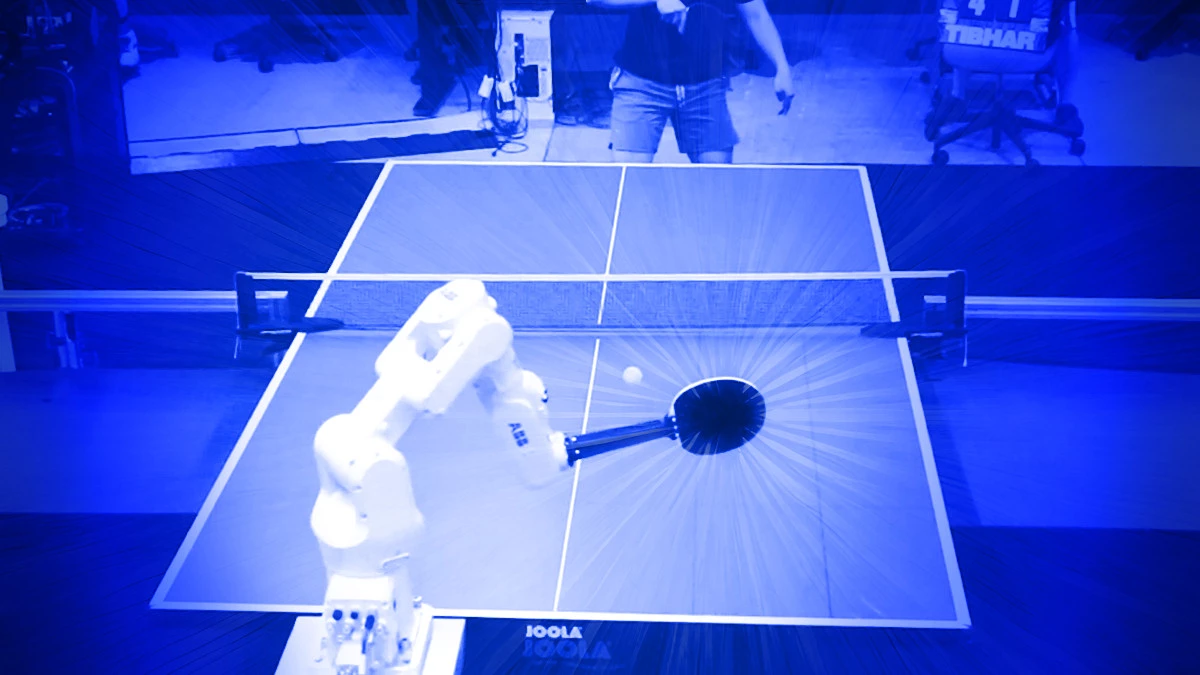

Google DeepMind использовала нейросеть, чтобы научить роботизированную руку обыгрывать в настольный теннис простых смертных. Впрочем, олимпийским чемпионам ещё рано бить тревогу, ведь пока что искусственный интеллект способен победить только посредственных игроков, да и то далеко не каждый раз.

Сегодня роботы умеют танцевать, выполнять акробатические трюки, наводить порядок и готовить, однако, несмотря на высокий уровень развития технологий, они всё ещё испытывают трудности с тем, чтобы быстро реагировать на информацию, получаемую из окружающего мира. К тому же в большинстве задач им пока не удалось достичь уровня точности и скорости, доступного человеку. Чтобы наконец одолеть эти ограничения, исследователи компании Google DeepMind разработали новую версию сверхмощного алгоритма глубинного обучения, который использует гибридный комплекс нейросетей и сложную архитектуру обработки данных, имитирующую мыслительные процессы внутри человеческого мозга, чтобы тот мог постепенно осваивать новую информацию. С тех пор как учёные начали работу над этим алгоритмом, ему удалось обыграть лучшего игрока в Го, предсказать структуру всех белков в человеческом теле и развязать несколько открытых математических проблем, над которыми лучшие математики нашей планеты ломали головы на протяжении десятилетий.

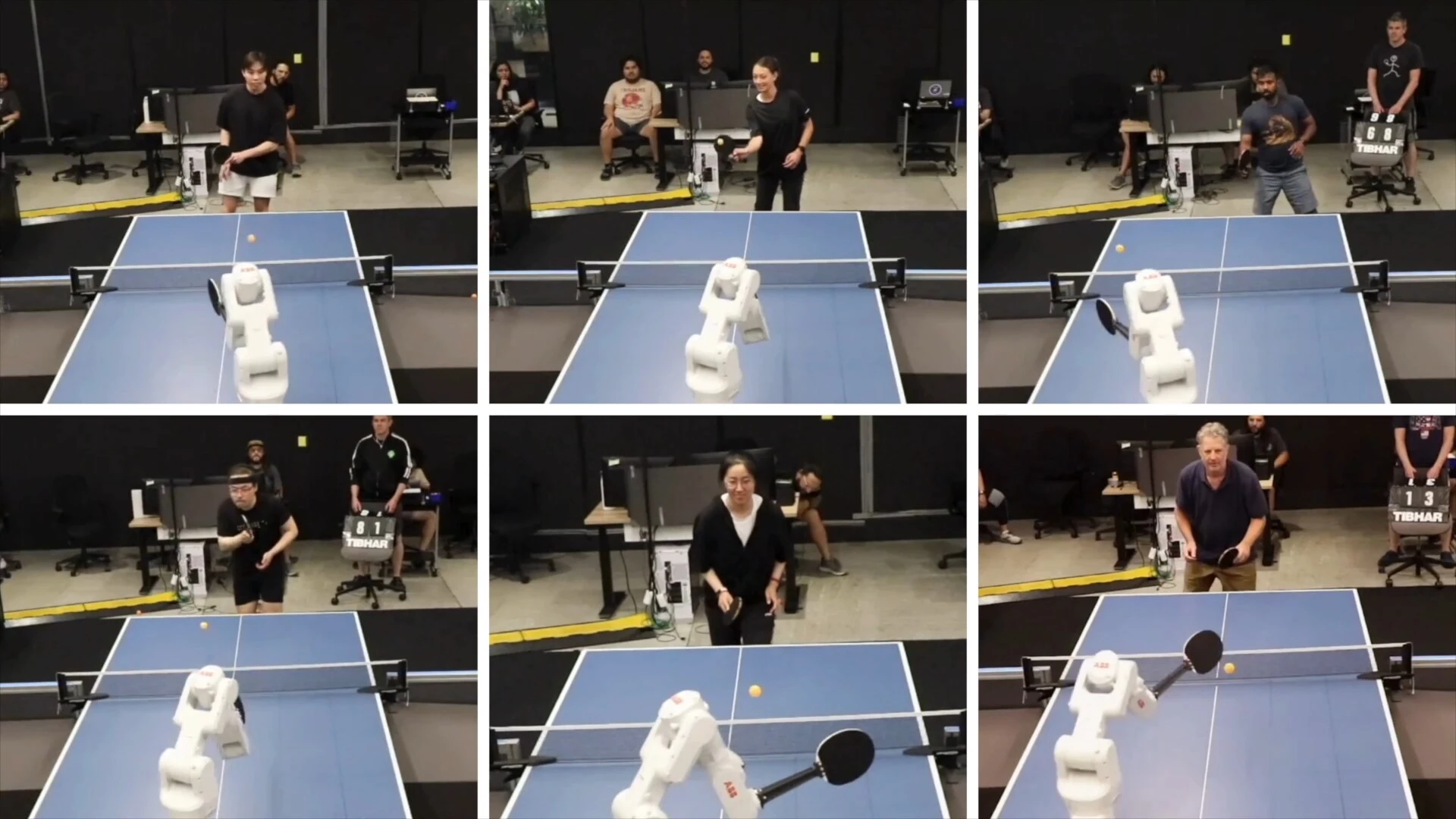

Настоящим испытанием для контролируемого ИИ робота стала серия матчей с 29 людьми. В итоге творение Google DeepMind обыграло всех начинающих игроков и обошло около 55% середнячков, но потерпело полный разгром, когда в качестве противников выступали опытные спортсмены. В соответствии с международными спортивными нормами система выступила на уровне с крепкими игроками-любителями. Стоит отметить, что, как и игроки из плоти и крови, роботизированная рука под управлением искусственного интеллекта имеет несколько систематических недостатков. К примеру, ей сложно даются высокие мячи и атакующий удар слева. Большинству людей понравилось играть с роботом, поскольку его навыки позволяли сделать матчи достаточно интересными для игроков разного уровня. В DeepMind считают, что подход, использованный учёными при обучении ИИ, будет актуальным для разных сфер, требующих от роботизированного агента динамической оценки ситуации и своевременной реакции на неё.