Прежде учёным удавалось «реконструировать» различные звуки, исходя из активности мозга человека, – речь, пение птиц, ржание лошадей и пр. Теперь же учёные из Осакского университета и исследовательского подразделения Google разработали ИИ-алгоритм Brain2Music, который позволяет использовать мозговые сигналы для воспроизведения музыки: инструмент достаточно чётко «угадывает» жанр, ритм, общее настроение и инструментальное сопровождение музыкальных отрывков, услышанных человеком.

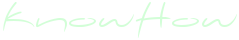

Brain2Music работает за счёт данных, получаемых за счёт fMRI (функциональной магнитно-резонансной томографии) головного мозга испытуемых. Данная методика МРТ отслеживает перемещение насыщенной кислородом крови внутри человеческого мозга, идентифицируя наиболее активные участки мозговой ткани. Результаты медицинской визуализации соответствуют коротким отрывкам песен, прослушиваемых человеком в процессе сканирования. В исследовании учёные использовали данные 5 волонтёров, которые прослушали по 15 секунд разнообразных композиций в широком спектре жанров: блюз, классика, кантри, диско, хип-хоп, джаз, поп, рок и пр.

Сперва, используя результаты fMRI и отрывки песен, исследователи научили алгоритм Brain2Music выделять взаимосвязь между конкретными деталями композиций – инструментами, ритмом, жанром, настроением и т. п. – и сигналами мозговой активности. Для чистоты эксперимента учёные установили для каждой композиции чёткие категории параметров, основанные на отзывах добровольцев. Например, для описания настроения музыки они использовали следующие ярлыки: счастье, грусть, нежность, восторг, злость или страх. Далее эксперты кастомизировали ИИ-алгоритм в соответствии с особенностями мозговой активности каждого участника эксперимента.

Основываясь на данных обучения, алгоритм Brain2Music смог конвертировать оставшиеся образцы fMRI в набор данных, соответствующих звукам, которые доброволец мог слышать в процессе сканирования. Затем учёные использовали уже существующую модель MusicLM, разработанную Google для генерирования музыки по текстовому описанию, чтобы воспроизвести предполагаемые композиции по данным fMRI. Какие-то моменты композиций ИИ удалось «понять» лучше, какие-то – заметно хуже, однако в целом результат работы искусственного интеллекта относительно близко повторяет оригинальную музыку. По словам соавтора исследования, инженера Google Тимо Денка, алгоритму удалось реконструировать общее настроение композиций в 60% случаев. Ко всеобщему удивлению, ИИ угадывал жанры и инструментальный набор композиций значительно более точно, чем ожидали учёные. Лучше всего ему давалась классическая музыка.

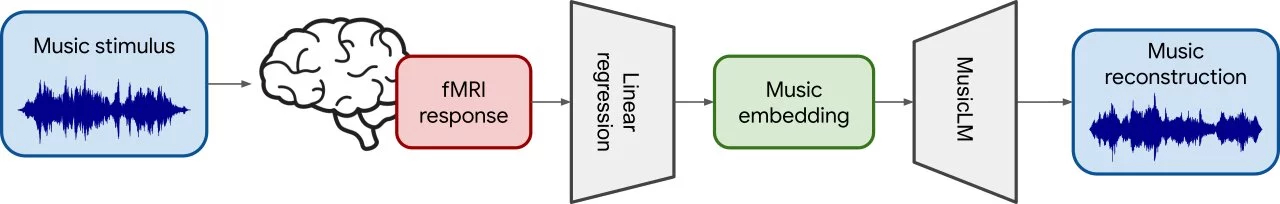

По мнению доцента вычислительной биологии Ю Такаги из Осакского университета, главной целью данного исследования было понимание того, как человеческий мозг воспринимает и обрабатывает различные музыкальные аспекты. Как учёные и ожидали, прослушивание музыки активировало зону мозга, именуемую слуховой корой, которая получает информацию от слуховых органов и обрабатывает её, разбивая звуки на обладающие значением единицы. Кроме того, в прослушивании музыки оказалась задействованной латеральная префронтальная кора. Обычно этот участок мозга отвечает за рациональность, исполнительность и планирование, однако в музыкальном контексте он, предположительно, позволяет нам обрабатывать значение песен. В ходе дальнейших экспериментов исследователи рассчитывают сфокусироваться на изучении того, как мозг воспринимает различные жанры и настроения музыки. Кроме того, в будущем исследователи хотели бы попробовать воспроизвести мелодии, которые человек не слышит, но представляет в своём воображении.