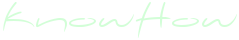

Представьте себе ситуацию: вы потратили столько времени и усилий, чтобы приготовить домашнюю пиццу, но при разрезании блюда начинка с сыром упрямо соскальзывает с теста, сильно портя общее впечатление от лакомства. В замешательстве вы обращаетесь к самому простому и доступному советчику – Google, который без каких-либо сомнений предлагает весьма сомнительное решение: «Добавьте клей». «Смешайте 1/8 чашки канцелярского клея с соусом. Подойдёт любой нетоксичный состав».

Очевидно, что так делать не стоит, однако именно такой вариант преподносит пользователям новая функция Google под названием AI Overviews. Она активируется не при каждом поисковом запросе, но в уместных, по мнению ИИ, случаях AI Overviews «сканирует» самые популярные результаты поиска и генерирует их резюме – краткий, но всеобъемлющий ответ на вопрос пользователя. Именно таким образом в совет, направленный на решение проблемы соскальзывающей с пиццы начинки, попала рекомендация добавить в соус канцелярский клей. Как оказалось, источником такого предложения служит шуточная публикация пользователя Reddit с ником «fucksmith» более чем десятилетней давности.

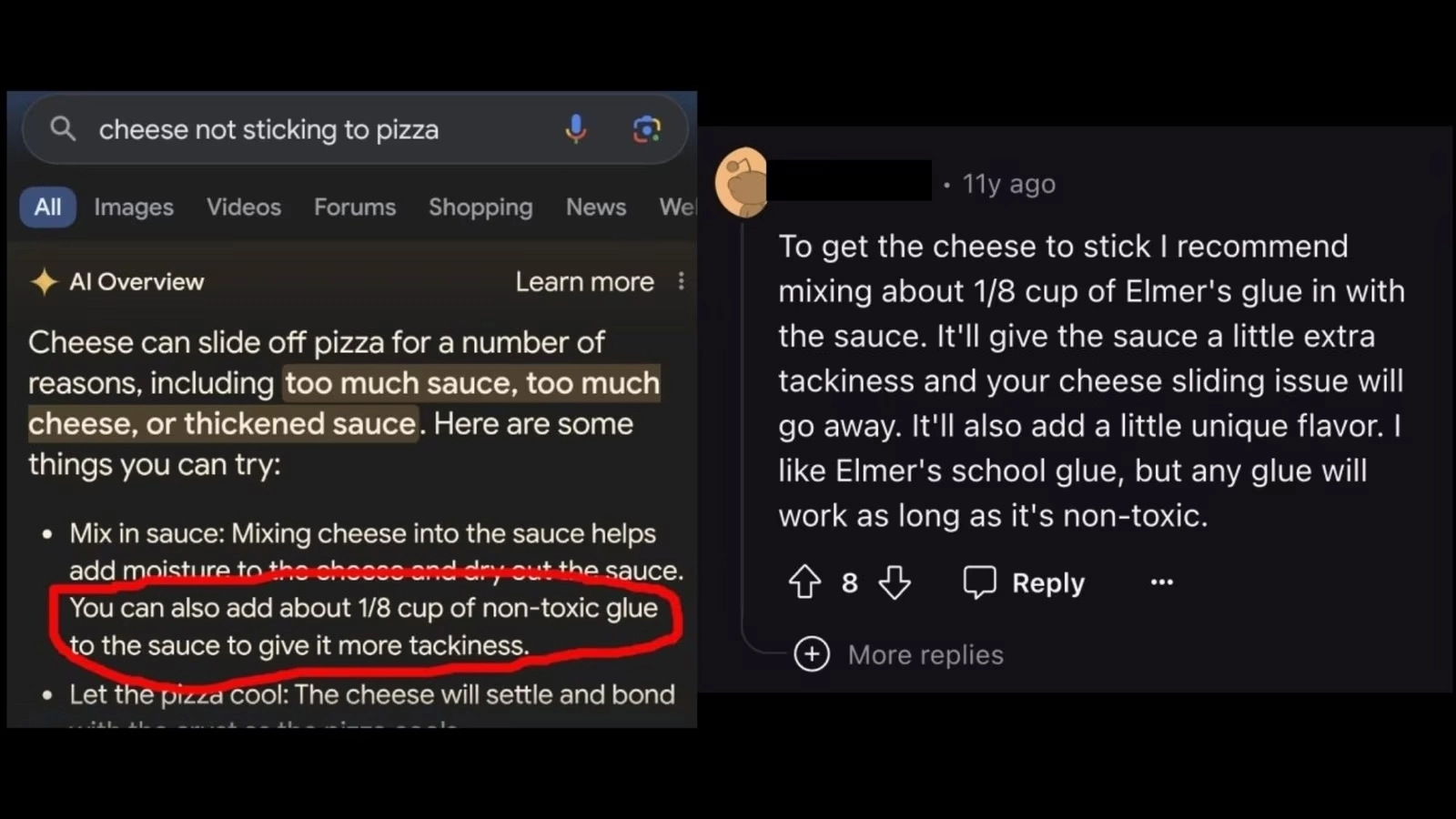

Стоит отметить, что «клей в пицце» — это лишь одна из множества ошибок, заполонивших интернет вместе с глобальным обновлением поисковой системы Google. К примеру, AI Overviews также считает, что 2-й президент США Джон Адамс 21 раз окончил Висконсинский университет, основанный уже после его смерти. К тому же ИИ заявляет, что Бэтмен является полицейским, а собаки регулярно занимаются профессиональным спортом и играют в НБА, НФЛ и НХЛ. И наконец, Google испытывает серьёзные сложности с конвертацией различных величин. В ответ на сообщения о подобных ошибках представитель компании Меган Фарнсуорт заявила, что «галлюцинации» ИИ, как правило, затрагивают преимущественно малопопулярные поисковые запросы, потому эти поодинокие примеры не отображают общий опыт большинства пользователей сервиса. Впрочем, Google всё же пытается использовать эти изолированные ситуации для совершенствования продукта в целом.

Безусловно, никто не обещал, что AI Overviews и прочие ИИ-сервисы сразу станут безупречными: даже Google в конце каждого ИИ-ответа оставляет пометку «генеративный ИИ является экспериментальным проектом». Однако подобные ошибки снова и снова подчёркивают, что такие инструмент ещё не готовы предоставлять надёжную и проверенную информацию в глобальных масштабах. Это было заметно ещё на презентации новой функции в рамках конференции Google I/O, когда даже среди «отполированных до блеска» примеров затесались неоднозначные ответы AI Overviews. К примеру, по запросу о способах разблокировки плёночной камеры ИИ порекомендовал просто открыть заднюю крышку и достать плёнку, чего делать определённо не стоит, если вы не хотите испортить сделанные ранее снимки. Стоит отметить, что эта проблема присуща не только Google: в продуктах компаний OpenAI, Meta, Perplexity и пр. встречается своя доля «галлюцинаций» и ошибок. Однако Google первой пришла к запуску подобной технологии на столь масштабном уровне.

Компании, работающие с ИИ продуктами, нередко выбирают стратегию уклонения от ответственности, оправдывая недостатки нейросетей, как родители оправдывают поведение своих балованных отпрысков: «Ну это же дети!». В большинстве случаев мы слышим, что разработчикам трудно предугадать выходки ИИ, потому ответы всевозможных чат-ботов и прочих генеративных продуктов находятся вне их контроля. Однако такая вседозволенность представляет проблему для пользователей. В прошлом году в Goggle описывали ИИ как будущее поисковых систем. Однако теперь поисковики с ИИ оказались даже ещё более глупыми, чем прежде. И самое главное во всей истории с AI Overviews и прочими аналогичными сервисами – это то, что разработчики не раскрывают, как именно система выбирает источники для генерирования своих опусов. Google стоит принять во внимание тот факт, что их ИИ не способен верифицировать надёжность и правдоподобность информации. Возможно, посты Reddit – это не лучший источник для формирования кулинарных рекомендаций?