Исследователи из лаборатории SAND Lab при Чикагском университете утверждают, что доступные широкой общественности программы клонирования голоса развиваются угрожающе быстро. В частности, создаваемые при помощи подобных технологий голосовые дипфейки могут сбить с толку как людей, так и смарт-устройства с голосовым управлением.

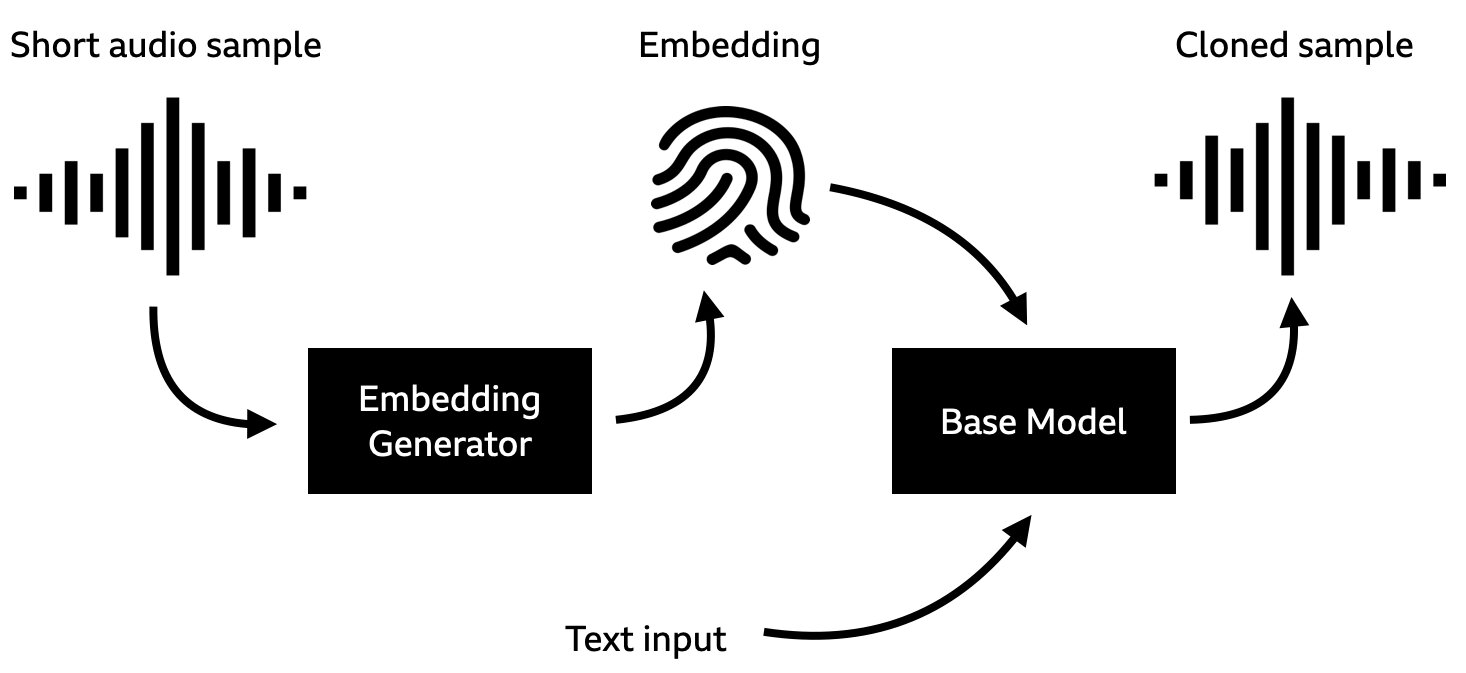

Команда экспертов из лаборатории SAND Lab (Security, Algorithms, Networking and Data Lab) протестировали доступные на платформе Github программы клонирования голоса, чтобы узнать, смогут ли они прорваться сквозь защиту системы безопасности распознавания голоса умных колонок Alexa, WeChat и Azure. Среди множества программ внимание учёных привлекла технология SV2TTS, создатели которой называют её «инструментом для клонирования голоса в режиме реального времени». По словам разработчиков, программа SV2TTS может синтезировать полноценные голосовые дипфейки, основываясь всего на 5 секундах записи оригинального голоса. Имитация голоса в исполнении SV2TTS смогла обойти защиту Azure от Microsoft в 30% случаев, а колонки Alexa и WeChat поддавались обману и того чаще – в 63%. Не менее ошеломляющие результаты показал эксперимент с 200 волонтёрами: примерно в половине случаев люди не смогли отличить голосовые дипфейки от реальных голосов.

Кроме того, исследователи пришли к выводу, что по какой-то причине синтезаторам речи гораздо лучше удаётся имитировать женские голоса, а также речь людей, для которых английский язык не является родным. По словам исследователей, современные механизмы защиты против синтезированной речи развиваются медленнее технологий имитации голоса. Не в тех руках подобные программы рискуют стать инструментом воплощения преступного замысла. При этом мишенью атаки могут стать как реальные люди, так и смарт-устройства. К примеру, колонка WeChat использует распознавание голоса пользователя для обеспечения доступа к платным функциям, например, для проведения транзакций в приложениях сторонних разработчиков вроде Uber или New Scientist.

Впрочем, изначально голосовые дипфейки заинтересовали учёных после новостей об использовании технологий имитации голоса для проворачивания крупных финансовых махинаций. В частности, в 2019 году руководитель британского подразделения одной энергетической компании получил звонок от начальства из Германии с требованием перевести более 240 тысяч долларов на счёт в Венгрии. По словам представителя страховой компании Эйлера Гермеса, «босс» пояснил, что транзакция необходима для предварительного погашения платежа без процентов. Хотя «жертва» посчитала такую просьбу несколько странной, голос начальника показался ей достаточно убедительным. Более того, программа смогла сымитировать не просто голос человека, но его тональность, интонации и немецкий акцент. Правда вскрылась, когда мошенники попытались провернуть тот же фокус во второй раз. Увы, полиция не смогла идентифицировать личности преступников, а вместе с ними не удалось найти и деньги.

По словам представителей компании Symantec, которая занимается разработкой ПО в области информационной безопасности, подобные случаи вовсе не единичны. Например, в 2020 году менеджер банка из ОАЭ получил аналогичный звонок. Служащему был хорошо знаком голос собеседника: он принадлежал главе одной из компаний, которая являлась постоянным клиентом его банка. Мошенник поделился радостными новостями о предстоящей крупной сделке, для осуществления которой было необходимо перевести 35 миллионов долларов. Кроме того, злоумышленник сообщил, что процедуру координирует юрист Мартин Зельнер. На электронной почте банка менеджер видел сообщения от юриста и предполагаемого главы компании, подтверждающие суммы и реквизиты переводов. Как следствие, он не задумываясь начал осуществлять транзакции. Письма на электронной почте и голосовые дипфейки оказались частью продуманной мошеннической операции, в которой, по данным полиции ОАЭ, были задействованы не менее 17 человек из разных стран.

Джейк Мур – эксперт в отрасли информационной безопасности из компании ESET – считает, что голосовые и видео-дипфейки представляют реальную угрозу безопасности информации, денег и деловых отношений на глобальном уровне. По мнению Мура, в обозримом будущем всё больше предприятий будут становиться жертвами высокотехнологичной преступной деятельности. К счастью, по мере осознания опасности недобросовестного использования ИИ-технологий на рынке стали набирать популярность компании вроде Pindrop Security, которые предлагают клиентам помощь в идентификации звонков, осуществляемых при помощи технологий имитации голоса.