Исследователи Facebook и Университета Карнеги-Меллона разработали алгоритм, который позволил нейросети под названием Pluribus овладеть мастерством игры в покер. По окончании обучения искусственный интеллект сумел обыграть сразу пятерых профессиональных игроков.

Покер-бот Pluribus с лёгкостью расправился с двумя признанными асами в мире покера – Дарреном Элиасом и Крисом Фергюсоном. Ещё совсем недавно считалось, что покер – уж слишком сложная игра для нейросети, поскольку, помимо чётких правил, важную роль в нём играет искусство блефа. Кроме того, в покере искусственному интеллекту приходится продумывать действия сразу нескольких оппонентов. Предыдущая версия нейросети Libratus достаточно неплохо показала себя в 2017 году, победив профессионалов в покере на двоих. Однако новый покер-бот пошёл дальше: он сумел расправиться со всеми противниками в стандартном техасском холдеме на шестерых.

В 1996 году компьютер Deep Blue впервые победил человека в игре в шахматы, а в 2017 году искусственный интеллект разобрался с китайской го – самой сложной в мире логической настольной игрой. В обоих случаях нейросеть имела постоянный доступ к базам данных, в которых были собраны всевозможные вариации ходов и расписаны методики и техники, используемые профессиональными игроками. В отличие от шахмат и го, во время игры в покер нейросеть Pluribus не может рассчитывать на информацию о подобных раскладах и ходах игры, так как она не видит карты остальных игроков. По сути, боту пришлось научиться «читать» оппонентов, исходя из видимых действий, и распознавать блеф.

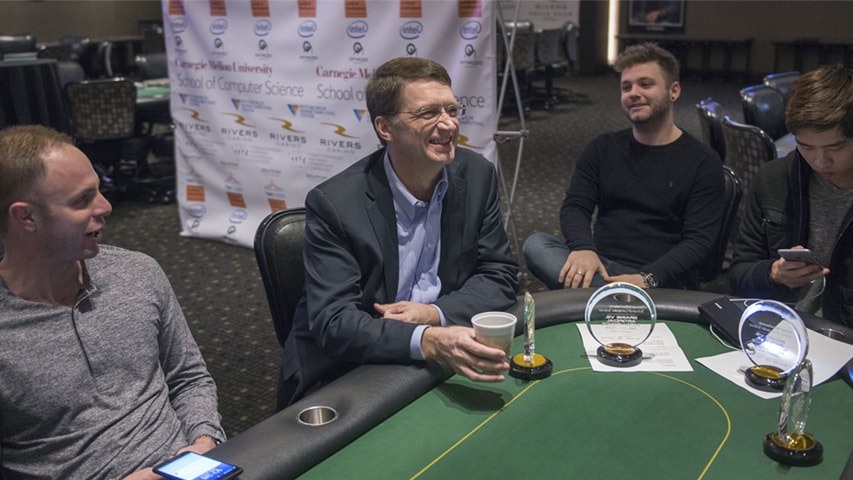

Более того, нейросеть Pluribus и сама неплохо освоила искусство блефа, следуя то консервативной, то агрессивной стратегии. Бот научился быть поистине непредсказуемым, вводя противников в ступор. На первом этапе эксперимента Даррен Элиас и Крис Фергюсон сыграли по 5 тысяч рук с пятью копиями покер-бота. Во втором этапе приняли участие 13 профессиональных игроков в покер, которые выиграли не один миллион долларов за свою карьеру. В этот раз один бот оказывался за столом сразу с пятью реальными людьми, но, несмотря ни на что, после 10 тысяч рук Pluribus вышел из игры победителем.

Представители Facebook поделились, что возможности обновлённой нейросети можно использовать для борьбы со случаями мошенничества в соцсетях, киберпреступностью и нежелательным контентом в интернете.