У 2024 році Google DeepMind продемонструвала робота, який завдяки штучному інтелекту навчився грати в теніс на рівні впевненого, але непрофесійного гравця. Тепер компанія показала нескінченний матч двох роботизованих рук, які мають вчитися та покращувати свої навички впродовж «вічної» гри.

Раннього вечора 22 червня 2010 року на Вімблдоні американський спортсмен Джон Існер розпочав гру проти француза Ніколя Маю. За 11 годин і 5 хвилин матч, який став рекордним за тривалістю, закінчився перемогою Існера із рахунком 70-68. Всього за годину їзди на південь від Всеанглійського клубу лаун-тенісу і крокету, де відбулася ця історична гра, в лабораторії Google DeepMind триває не менш дивовижна гра у теніс між двома неочікуваними конкурентами. DeepMind, відома за передовими ШІ-моделями, які перевершили найкращих гравців у шахи та го, вже не перший рік підкорює новий спорт. Дві роботизовані руки є частиною проєкту, який стартував у 2022 році. Залучені до нескінченного тенісного матчу, вони мають безперервно вчитися один від одного, використовуючи штучний інтелект для адаптації стратегії гри та удосконалення своїх навичок.

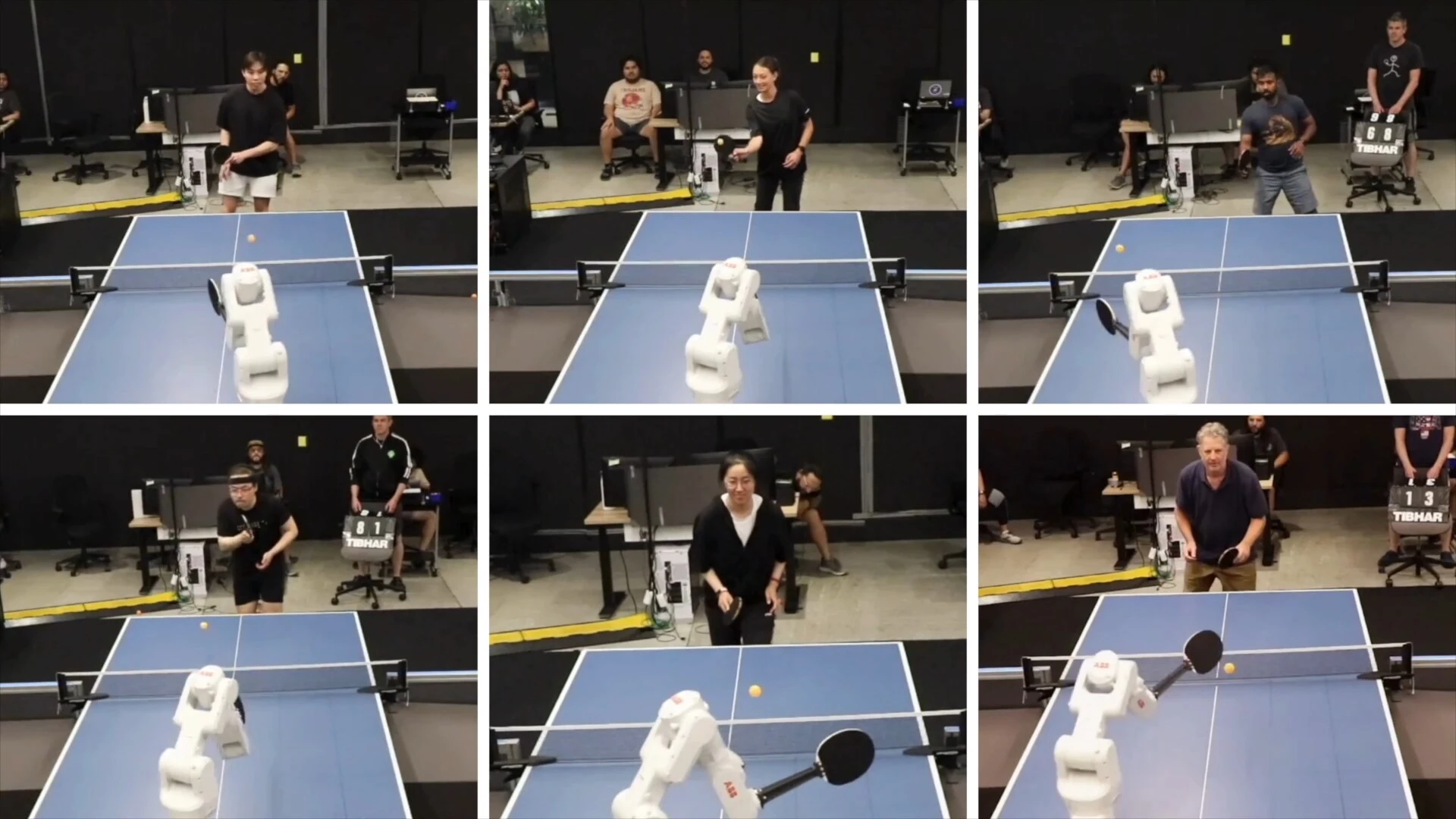

На відміну від матчу Існера та Маю, ця гра не має кінцевого рахунку. Роботи змагатимуться один з одним, з кожною подачею покращуючи свій результат. Раніше в DeepMind випробовували ефективність робота проти людини, і виявилося, що досвідчені гравці легко його перевершують, зі спортсменами середнього рівня шанс перемоги сторін ставав рівним і лише початківці поступалися йому в більшості матчів. Втім, інженери Google сповнені оптимізмом та очікують, що подальший розвиток алгоритмів допоможе створити модель штучного інтелекту загального призначення, яка могла б стати «мозком» для людиноподібних роботів, що займуть місце поряд з людьми на виробництвах і в побуті та зможуть на льоту засвоювати нові навички.

Виявилося, що теніс є надзвичайно ефективним інструментом відпрацювання непередбачуваності процесів. Цей спорт слугує бенчмарком у світі робототехніки ще з 1980-х років, оскільки він вимагає високої продуктивності в низці важливих аспектів, як от швидкість, здатність до адекватного реагування та адаптації стратегії руху. Щоб навчитися грати в теніс, людина має розвивати дрібну моторику та реакцію, щоб відстежувати розташування м’яча, який може мати різні параметри польоту від однієї подачі до іншої. Водночас необхідно мати розуміння стратегії та вміння оцінювати сильні й слабкі сторони опонента, щоб змінювати власні дії задля перемоги. Іншими словами, теніс створює дуже обмежене, але водночас максимально динамічне середовище, ідеальне для навчання штучного інтелекту.

Виявилося, що теніс є надзвичайно ефективним інструментом відпрацювання непередбачуваності процесів. Цей спорт слугує бенчмарком у світі робототехніки ще з 1980-х років, оскільки він вимагає високої продуктивності в низці важливих аспектів, як от швидкість, здатність до адекватного реагування та адаптації стратегії руху. Щоб навчитися грати в теніс, людина має розвивати дрібну моторику та реакцію, щоб відстежувати розташування м’яча, який може мати різні параметри польоту від однієї подачі до іншої. Водночас необхідно мати розуміння стратегії та вміння оцінювати сильні й слабкі сторони опонента, щоб змінювати власні дії задля перемоги. Іншими словами, теніс створює дуже обмежене, але водночас максимально динамічне середовище, ідеальне для навчання штучного інтелекту.

Щоб навчити роботизовані руки основам тенісу, інженери DeepMind розпочали проєкт з навчання з підкріпленням: ШІ отримував певну винагороду за дотримання правил та прийняття правильних рішень. На цьому етапі роботи-конкуренти не мали мотивації перемогти, але могли грати один проти одного. Згодом завдяки тонкому налаштуванню алгоритмів дослідники навчили роботів автономно підтримувати процес гри в теніс впродовж тривалого часу. З появою інструкції конкуренції роботи стали більш зацікавленими у тому, щоб заробити бали за вдалі подачі, але разом з тим почали з’являтися й проблеми. ШІ став прагнути засвоїти нову інформацію та опанувати нові тактики, забуваючи базові рухи, яким він навчився раніше. Результатом стала низка коротких матчів, які закінчувалися насиллям з боку робота, який програв.

Щоб навчити роботизовані руки основам тенісу, інженери DeepMind розпочали проєкт з навчання з підкріпленням: ШІ отримував певну винагороду за дотримання правил та прийняття правильних рішень. На цьому етапі роботи-конкуренти не мали мотивації перемогти, але могли грати один проти одного. Згодом завдяки тонкому налаштуванню алгоритмів дослідники навчили роботів автономно підтримувати процес гри в теніс впродовж тривалого часу. З появою інструкції конкуренції роботи стали більш зацікавленими у тому, щоб заробити бали за вдалі подачі, але разом з тим почали з’являтися й проблеми. ШІ став прагнути засвоїти нову інформацію та опанувати нові тактики, забуваючи базові рухи, яким він навчився раніше. Результатом стала низка коротких матчів, які закінчувалися насиллям з боку робота, який програв.

Вміння грати в теніс може здаватися занадто вузькоспеціалізованим для роботів, які могли б стати корисними в інших галузях людського життя, окрім спорту. Насправді ж навчання штучного інтелекту та роботів у процесі такої вимогливої до реакції та стратегії гри допомагає дослідникам винаходити нові ефективні методики удосконалення численних аспектів робототехніки та систем глибинного навчання, які можна буде використати в майбутньому.

Вміння грати в теніс може здаватися занадто вузькоспеціалізованим для роботів, які могли б стати корисними в інших галузях людського життя, окрім спорту. Насправді ж навчання штучного інтелекту та роботів у процесі такої вимогливої до реакції та стратегії гри допомагає дослідникам винаходити нові ефективні методики удосконалення численних аспектів робототехніки та систем глибинного навчання, які можна буде використати в майбутньому.

Джерело зображень: Google DeepMind